Inteligencia artificial

Desde Twitter hasta Apple: 1.100 firmantes piden pausar los avances en inteligencia artificial por 6 meses

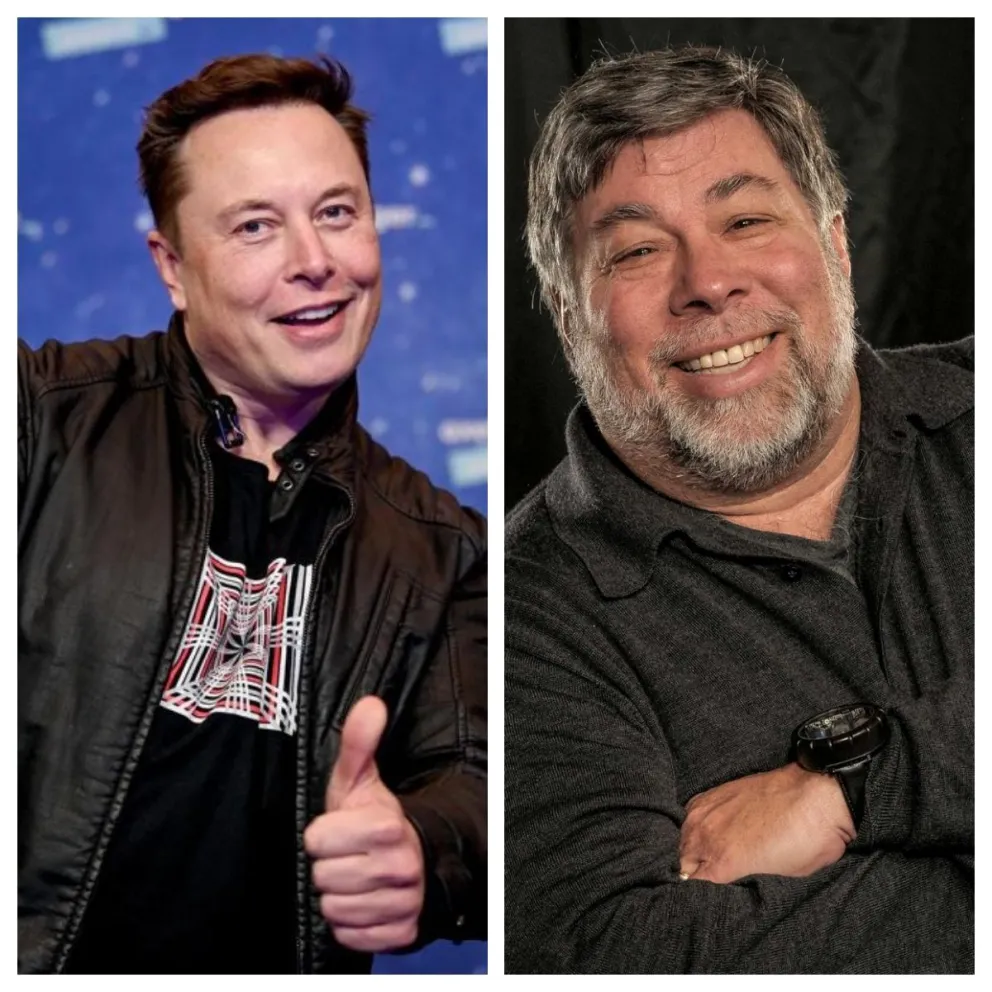

Más de 1.100 firmantes de alto perfil, incluyendo a Elon Musk, Steve Wozniak y Tristan Harris, pidieron a los laboratorios de inteligencia artificial pausar sus entrenamientos de plataformas más potentes que GPT-4 por 6 meses.

Dichas figuras defendieron en la carta abierta que “los sistemas contemporáneos de IA se están volviendo humanamente competitivos en tareas generales, y debemos preguntarnos: ¿deberíamos dejar a las máquinas inundar nuestros canales de información con propaganda y mentiras?”.

“¿Deberíamos automatizar todos los trabajos, incluyendo los satisfactorios? ¿Deberíamos desarrollar mentes no humanas que puedan eventualmente superarnos en número y en inteligencia, volviéndonos obsoletos y reemplazándonos? Deberíamos arriesgar perder el control de nuestra civilización?”, se preguntan los firmantes, que incluye también a investigadores, académicos, y ejecutivos de empresas tecnológicas como Skype, Pinterest, Meta y Google.

En este sentido, fundamentan que “tales decisiones no deben ser delegadas a líderes tecnológicos no electos. Sistemas de IA poderosos deberían ser desarrollados sólo una vez que estemos confiados en que sus efectos serán positivos y sus riesgos manejables”.

Asimismo, argumentan que falta “planificación y administración” en los avances recientes de IA, enfrascándose en un “carreras fuera de control para desarrollar y desplegar mentes digitales cada vez más poderosas que nadie -ni siquiera sus creadores- pueden entender, predecir, o controlar fiablemente”.

Por ello, piden una pausa “pública y verificable” que involucre a todos los actores clave de esta industria, potencialmente involucrando intervención de los gobiernos.

“Esto no significa una pausa en el desarrollo de la IA en general, simplemente un paso atrás de la carrera peligrosa hacia modelos de caja negra impredecibles cada vez más grandes con capacidades emergentes”, matizan en la misiva, publicada en el Future of Life Institute.

También destacan la necesidad de trabajar de forma conjunta con los legisladores, para avanzar en el desarrollo de sistemas sólidos de gobierno de IA, que además de garantizar un desarrollo seguro de esta tecnología, permita su auditoría y supervisión y el seguimiento de los responsables en caso de fugas o daños, para que puedan responder por ellos.